Я уже много лет пытаюсь найти идеальный для себя метод для хранения файлов. Думаю я его нашел, но всегда есть что улучшить, если есть какие-то мысли как сделать лучше, с удовольствием почитаю.

Начну с того что расскажу пару слов о себе, я занимаюсь веб разработкой и в свободное время фотографирую. Отсюда вывод что хранить мне нужно рабочие и личные проекты, фото, видео ну и другие файлы.

У меня где-то 680 GB файлов, из них процентов 90 это фото и видео.

Круговорот файлов в моих хранилищах:

Тут примерная схема того как и где хранятся все мои файлы.

Теперь подробнее.

Как видно, сердцем всего является мой NAS, а именно Synology DS214, один из самых простых NAS-ов у компании Synology, тем не менее со всем что мне нужно он справляется.

Dropbox

Рабочая машина у меня macbook pro 13, 2015 года. У меня там 512GB но помещаются само собой не все файлы, храню только то что нужно на данный момент. Все свои личные файлы и папки синхронизирую с Dropbox-ом, знаю что это не очень надежно, но он выполняет только функцию синхронизации. И делает он это лучше всего, по крайней мере из того что я перепробовал. А перепробовал я все знаменитые и не очень облака.

У Synology так же есть свое облако, можно его развернуть на своем NAS-е, я несколько раз пробовал пересесть с Dropbox на Synology Cloud Station, но там всегда были проблемы с синхронизацией, всегда какие-то ошибки, или не все синхронизировал.

Все важные файлы хранятся в папке Dropbox, иногда я сохраняю что-то на рабочий стол, чтоб что-то не потерять сделал симлинк в папку Dropbox при помощи программы MacDropAny.

Папка Download у меня никак не синхронизируется но там и нет ничего важного, только временные файлы. Если качаю что-то важное, то копирую в соответствующую папку в Dropbox.

Когда-то давно, где-то в 2013-2014 я хранил все файлы в Dropbox-e и только в нем, не было никаких бэкапов. Тогда у меня не было 1Тb, то есть я не платил за него, у меня было где-то 25Gb, которые я заработал путем приглашения друзей или других заданий.

В одно прекрасное утро я включил компьютер и все мои файлы исчезли, так же получил письмо от Dropbox где они извиняются и что файлы мои пропали по их вине. Они дали мне ссылку по которой я мог восстановить свои файлы но само собой ничего не восстановились. За то они подарили мне на год 1Tb, после чего я стал их клиентом, как бы странно это не звучало, но никогда им не доверял.

Как писал выше, не смог найти более подходящее для меня облако, во первых еще не было проблем синхронизации, во вторых много всяких сервисов работают только с Dropbox.

Файлы по работе хранятся на рабочем сервере, личные проекты на GitLab-е, тут все просто.

Time Machine

Так же я делаю бэкап всей системы, исключая папку Dropbox и Downloads само собой, чтоб не занимать зря место. Бэкап системы делаю через Time Machine, отличный инструмент, не раз выручал. Делаю на том же NAS-е, благо там есть такая функция. Можно делать и на внешний HDD конечно, но это не так удобно. Нужно каждый раз подключать внешний диск и самому запускать Time Machine. Из-за лени, часто такие бэкапы делал раз в несколько недель. На сервер же он автоматом делает бэкап, я даже не замечаю когда он это делает. Я работаю из дому, так что у меня всегда есть свежая резервная копия всей моей системы. Делаются копию несколько раз за день, не считал сколько раз и как часто.

Тут и происходит вся магия.

У Synology есть отличный инструмент, называется он Cloud Sync, думаю по названию понятно что он делает.

Он может синхронизировать многие облачные системы между собой, если точнее то синхронизировать файлы с сервера NAS c другими облаками. Обзор данной программы думаю есть в сети. не буду вдаваться в подробности. Лучше опишу как я ее использую.

На сервере у меня есть папка диск под названием Dropbox, она является копией моего Dropbox аккаунта, синхронизацией всего этого занимается Cloud Sync. Если в Dropbox-е что-то произошло с файлами, это произойдет и на сервере, не важно, едит\удаление\создание. В общем классическая синхронизация.

Яндекс диск

Далее, все эти файлы я кидаю на свой Яндекс диск, его я использую как самодельный бэкап диск, то есть файлы туда кидаю но ничего не удаляю оттуда, получается такая свалка файлов, но пару раз выручало.

Google Drive

Туда я отправляю только папку «Photos», так же в режиме синхронизации, делаю я это только для удобного просмотра фото в гугл фото и с возможностью удаления оттуда фото и они удаляются везде (кроме яндекс диска само собой). Про фото я напишу ниже, там вообще можно отдельную статью написать.

HyperBackup

Но все это не очень надежно, если случайно удалил файл то он везде удалится и можно считать его потерянным. Можно конечно восстановить из яндекс диска, но во первых бэкап в одном месте не очень надежен сам по себе, да и сам яндекс диск, не тот сервис в котором можно быть уверенным на 100%, хоть с ним еще ни разу не было проблем.

Поэтому я всегда старался хранить файлы еще где-то, уже с нормальной системой бэкапов.

У Synology так же есть инструмент для этого, называется он HyperBackup, он делает бэкап файлов либо на другие серверы Synology, либо на какие-то клауд решения от сторонних производителей.

Также он умеет делать бэкап на внешние диски, подключенные к NAS-y, так я и делал до недавних пор. Но это тоже не надежно, к примеру если пожар то конец и серверу и HDD.

Synology C2

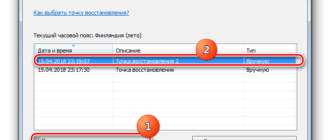

Тут мы плавно подходим к другому сервису, уже от самой Synology. У нее есть свои облака для хранения бэкапов. Заточен он именно под HyperBackup, он делает туда бэкап каждый день, но это уже продуманный backup, там есть версии файлов, таймлайн и даже клиенты для windows и mac os.

На этом, с хранением файлов все, надеюсь мои файлы в сохранности.

Теперь перейдем к сортингу файлов.

Обычные файлы, книги, сканы документов и другие маловажные файлы я как и все сортирую по папкам руками. Обычно их не много и открываю я их редко.

Самое сложное с сортировкой фото и видео, у меня их много.

Фото я делаю от нескольких десятков до несколько сотен в месяц. Снимаю на зеркалку, на дрон и иногда на телефоне. Фото бывают личные и для стоков. Также иногда снимаю домашнее видео (не то что вы подумали, просто семейные видео, чаще с дочкой). Его тоже надо как-то хранить и сортировать, чтоб не была каша.

У меня есть папка в том же Dropbox-е, под названием Sort Images, там есть подпапки куда попадают все фото и видео, оттуда они берутся и сортируются куда надо.

Сортировка происходит на сервере NAS, там работают bash скрипты которые автоматом запускаются раз в сутки и делают свою работу. За их запуск также отвечает NAS, там есть планировщик задач который и отвечает за запуск всех скриптов и других задач. Можно настроить как часто и когда будут запускаться задачи, крон с интерфейсом если проще.

Для каждой папки есть свой скрипт. Теперь подробнее о папках:

Drone — тут попадают фото с дрона которые я снял в личных целях. Сначала я обрабатываю все фото в lightroom, потом делаю экспорт JPG в эту папку. оттуда они попадают в другую папку Dropbox, «Photo».

Там есть папка «Drone» и там уже они сортируются по годам и месяцам. Скрипты сами создают необходимые папки и переименовывают сами фото по моему шаблону, обычно это дата и время снятия фото, так же добавляю в конце рандомную цифру, чтоб не получались файлы с одним и тем же именем. Не помню почему для этих целей не подходило выставление секунд в имени файла.

Дерево имеет такой вид: Photo/Drone/2019/05 — May/01 — May — 2019_19.25.53_37.jpg

Drone Video — я пока что не снимаю видео дроном, там нужно многое учить, нет для этого сейчас времени, но папку уже создал.

Images Operations — тут внутри две папки, когда файлы там попадаются то они просто либо сжимаются по максимальной стороне до 2000px для публикации в интернете либо делается флип картинок, это уже мне не нужно, но пока что папку не удалил.

Panoramas — тут попадают как не сложно догадаться панорамы, их я храню отдельно так как это специфический вид фото, обычно делаю их дроном. Я делаю и обычные панорамы но так же делаю 360 панорамы и иногда сферы, такой вид панорам как маленькие планеты, делаю так же дроном. Из этой папки все фото попадают также в Photo/Panoramas/2019/01 — May — 2019_19.25.53_37.jpg. Тут я не делаю сортировку по месяцам так как панорам не так уж много.

Personal Photo — Тут попадают фото которые делаю на зеркалку, обычно это семейные фото или же путешествия, в общем фото которые делаются на память и для себя. Так же сырые фото обрабатываю а lightroom-е и потом экспортирую сюда.

Отсюда они попадают сюда: Photo/2019/05 — May/01 — May — 2019_19.25.53_37.jpg

Если же я снял какой-то торжество или еще что-то что лучше бы хранить отдельно то в папке 2019 создаю папку с названием торжества и копирую туда фото руками.

RAW — тут попадают исходники фото. я всегда снимаю в RAW, все фото храню в JPG но иногда хочется хранить также и RAW файлы, иногда хочется по другому обработать какой-то кадр. Обычно это природа и туда попадают только лучшие кадры, не все подряд.

Stock Photo — сюда я скидываю фото для стоков, которые делаю либо на зеркалку, либо на дрон. Сортировка такая же как и на других фото, просто в свою отдельную папку.

В корневой директории Dropbox, есть папка Camera Uploads, это дефолтная папка в которую мобильное приложение Dropbox скидывает туда все фото и видео. Все фото жены с телефона скидываются таким образом. Я так же все свои фото и видео с телефона скидываю сюда и отсюда уже сортирую в отдельную папку. Но я делаю это иным способом, более удобным для меня. Есть такая программа для Android, FolderSync, она позволяет брать все фото с мобилы, закачать их на Dropbox и потом удалить их с телефона. Там множество настроек, рекомендую. В эту папку попадают и видео с телефона, они также сортируются как и все фото, по годам и месяцам.

Все скрипты я собрал сам из всяких инструкций в интернете, готовых решений не нашел. Я вообще ничего не знаю про баш скрипты, возможно есть какие-то ошибки или какие-то вещи можно было бы сделать лучше, но самое главное — для меня, они справляются со своей работой и делают то что мне надо.

Раньше для сортировки фото, видео я использовал Hazel под mac os, там само собой все легче, там все задачи создаются визуально, не надо писать код, но тут есть два минуса. Во первых нужно держать все папки на компьютере, чтоб все хорошо работало и второе, если вдруг пересяду на windows или linux то там нет таких программ. Пробовал искать альтернативу но все они были ни о чем. А решение со скриптами на сервере более универсальное решение.

Все скрипты настроены чтобы выполнялись раз в сутки, обычно ночью. Но если нет времени ждать и нужно как-то выполнить нужный скрипт сейчас, есть два решения, подключиться по SSH к серверу и выполнить нужный скрипт или же зайти в админку и так же мануально запустить нужный скрипт. Все это мне кажется не удобным, поэтому я нашел третье решение. Есть программа под Android, она может отправлять команды ssh. Я создал несколько команд, для каждой есть своя кнопка и теперь если мне нужно отсортировать например фото которые сделал с дрона то просто нажимаю одну кнопку и скрипт срабатывает. Программа называется SSHing, есть и другие похожие, но для меня эта самая удобная.

Так же у меня несколько своих сайтов, они больше для галочки, туда практически никто не заходит но все же backup делать не помешает. Сайты я держу на DigitalOcean, там установил панель aaPanel. Там есть возможность сделать резервные копии всех файлов и всех баз данных, но на том же диске.

Хранить бэкап на том же диске не дело, поэтому я так же через bash скрипт стучусь туда и копирую все на свой сервер, архивируя все в одном архиве с датой в названии.

Надеюсь хоть кому-то помогут способы, что я использую и какими поделился.

Как видно из статьи, я люблю автоматизацию и стараюсь автоматизировать что все что только можно, я многие вещи не описывал с точки зрения автоматизации, так как это уже другие темы и другие статьи.

AdBlock похитил этот баннер, но баннеры не зубы — отрастут

Читают сейчас

Редакторский дайджест

Присылаем лучшие статьи раз в месяц

Скоро на этот адрес придет письмо. Подтвердите подписку, если всё в силе.

- Скопировать ссылку

- ВКонтакте

- Telegram

Похожие публикации

Создание документов на диске Google на базе событий в CRM-системах: аmoCRM и Битрикс24

Баг в Google Drive позволяет подменять обычные файлы вредоносными

Dropbox-лайт или мой рабочий стол в интернете

Вакансии

AdBlock похитил этот баннер, но баннеры не зубы — отрастут

Минуточку внимания

Комментарии 38

Добрый день! Интересно, спасибо.

Synology — лучшие для семейно-бытового и мелко-офисного использования (у меня однодисковые DS115 и DS116, синхронизируются через Яндекс. Диск, находятся в разных домохозяйствах; объем семейных файлов сопоставим).

— есть такая проблема, что у Synology Cloud Station что у Synology Drive. И вот что интересно — эти инструменты нормально справляются с ролью «сервер синхронизации внутри локальной сети» предположительно при объемах синхронизируемых файлов в сумме до 50 GB, а если больше — начинаются тормоза и косяки. У нас школьные материалы через папку Synology Drive прекрасно синхронизируются между тремя компьютерами — чтобы что-то можно было сделать на любом, независимо от доступности (занятости) родственников; объем менее 10 GB; Была попытка использовать как такой же сервер синхронизации для всего фото-видео архива (600+ GB) — на третий день тихого шуршания вентилятором синхронизировалось процентов 8 и стало понятно, что лучше дальше машинку не мучить).

Поделитесь пожалуйста — 2 жестких диска сконфигурированы в RAID 1? Какие жесткие диски используете и сколько лет?

— читателям возможно будет интересно, что клиенты под настольные операционки могут оказаться спасителями в ситуации, когда NAS (или установленные диски) сбойнула, но (многоверсионный) архив Hyperbackup доступен либо в облаке Synology C2 либо на внешнем USB-диске, на который бэкапилась NAS — с помощью клиентов можно просмотреть версии файлов, начать восстановление на комп.

Ну и кстати вопрос — из статьи вроде следует, что не используется локальный многоверсионный бэкап Hyperbackup на внешний USB-диск, подключенный к NAS. Считаете достаточным (надежным и избыточным) облачные синхронизации и архивирования? А вот как быть с риском «отключат интернет»? (понятно, что локальные файлы на NAS и компах тут ни причем однако накопленный многоверсионный архив тоже представляет собой «долгосрочную» ценность — для спокойствия души). Задаю вопрос потому что: а) периодически переоцениваю методологии и технологии синхронизаций и архивирований с точки зрения повышения защищенности от самых разных проблем (аварии оборудования (носителей), ошибки пользователей, ошибки разработчиков софта (невозможность восстановиться из архива), ситуации «отключат всё». ); б) судя по всему, затраты на облачные подписки у вас не маленькие и однократные затраты на один внешний диск тут значения не имеют (а софт не нужен — он уже есть — Synology-пакет Hyperbackup).

Спасибо за такой развернутый комментарий ![]()

да, не понимаю почему за столько лет Synology так и не поправило свои баги.

Да. Использую два диска в RAID 1, Western Digital Caviar Red 2Tb (WD20EFRX), купил я их в начале 2014, вместе с NAS. Работали они почти непрерывно и пока полет нормальный, никаких нареканий. Они созданы специально для NAS.

Да. все верно. Некоторые вещи забыл упомянуть.

А почему не используете Synology Drive — аналог Google Drive, отпадет необходимость в Dropbox?

Synology Moments — аналог Google Photo?

Коллеги, дополню мысль насчет Synology Cloud Station и у Synology Drive:

1) наши Synology «близко к начальному уровню»[прим. 1] (у автора статьи — двухдисковая DS214, у меня однодисковые DS115 и DS116) прекрасно справляются с ролью «клиент облачного сервиса» (Яндекс. Диска, Google. Диска и прочих) — ведь для выполнения операций дву — или односторонней синхронизации не очень важны процессорные мощности и объем ОЗУ собственно NAS, — гораздо важнее а) производительность самого облачного сервиса (выше я писал про OneDrive, который гораздо медленнее других); б) скорость интернет-соединения. Само собой, что уровень текущей (в конкретный момент) производительности NAS в этой роли не зависит от объема данных (условно, при первоначальной синхронизации, 2 TB будут синхронизироваться в 2 раза дольше, чем 1 ТВ, — 20 суток вместо 10) и даже если в этой роли использовать гораздо более мощный NAS, то картина сильно не поменяется;

2) совсем другая история, если мы попытаемся немощный (избегаю слова маломощный) NAS использовать в роли «сервер для синхронизации нескольких устройств в локальной сети (для группы сотрудников, малого офиса, подразделения. )». Тут задач на стороне NAS побольше — и, возможно, слабых процессоров и ОЗУ 0,5 — 1 (2?) GB недостаточно. В моем случае DS116 в роли сервера (средствами Synology Drive) в локальной сети отлично синхронизирует одну папку на 3 устройства (которые далеко не всегда работают одновременно), объем папки 10 GB (при этом, само собой, эта папка по расписанию HyperBackup-ится на внешний USB-диск, эта операция тоже никак не напрягает машинку DS116; ну предположительно, все будет хорошо и с 5 устройствами, и с объемом… допустим до 100 GB).

А вот если объем примерно полтерабайта — судя по всему, если нужна роль сервера, придется использовать более мощную NAS (кстати у Synology отличный модельный ряд — можно выбирать по нескольким направлениям — многодисковые не очень мощные, малодисковые мощные, многодисковые мощные. ) — при этом нужно понимать, что мощность подразумевает под собой больший расход электроэнергии, большую шумность, и т. п.

Я нисколько не расстроен тем, что моя экспериментальная попытка получить роль сервера не удалась — мои Synology отлично справляются с ролью полностью автоматических:

— клиентов-синхронизаторов (из облаков и в облака нескольких провайдеров);

— бэкаперов (многоверсионные архивы, с поддержкой дедупликации; с возможностью проверок по расписанию — отдельно индексов, отдельно — и индексов и архива).

При этом мои Synology:

— отлично засыпают в течение дня — после нескольких напряженных недель первоначальных синхронизаций и полных бэкапов — особой нагрузки нет;

— работают еле слышно (а благодаря низкому энергопотреблению начинки (без учета жесткого диска) режим работы вентилятора выставлен в самый минимальный режим, предполагающий возможность остановки вентилятора, если температура системы приемлемая — то есть машинка (и диск) работают, а вентилятор отдыхает);

На всякий случай подчеркну, что мощности этих NAS вполне достаточно для просмотра видео на DLNA-совместимых получателях, ну и так далее.

[примечание 1]

NAS совсем начального уровня у Synology имеют индекс J в обозначении модели. это странноватые конфигурации — начинка гораздо слабее, есть ограничения в функционале, при этом цена лишь на несколько тысяч российских рублей меньше, чем близкие модели без индекса J.

Секреты Synology. Обходим ограничения и расширяем возможности популярных NAS

Что конкретно стоит изменить? В список входит странная реализация агрегации сетевых портов, не позволяющая удвоить пропускную способность при работе с единственным клиентом, отсутствие штатных способов увеличить скорость сетевого интерфейса, шумная работа вентилятора в простое даже в тех моделях, процессор которых не нуждается в активном охлаждении.

Агрегация портов: как на самом деле удвоить скорость сетевого интерфейса

Скорость современных жестких дисков часто превышает 200 Мбайт/с, а использование некоторых типов многодисковых массивов позволяет достичь и более высоких скоростей. Использование в сетевых хранилищах единственного гигабитного сетевого порта убивает удовольствие на корню: получить скорость, превышающую 125 Мбайт/с, с единственным гигабитным соединением невозможно. В статье «После гигабита. Выбираем и настраиваем оборудование для суперскоростной домашней сети» я уже успел пожаловаться на проблему, описав и вариант решения — купить и настроить мультигигабитный адаптер. Сейчас же я расскажу о том, как обойтись без него и удвоить скорость гигабитного соединения совершенно бесплатно.

Ряд моделей Synology — например, DS718+, DS220+, DS720+, DS420+ и более продвинутые — оснащены двумя или более гигабитными сетевыми портами. Пользователи QNAP или Asustor пожмут плечами: отлично, делаем агрегацию — скорость удваивается! Однако в NAS от Synology использовать лишний порт для того, чтобы просто удвоить полосу пропускания, у обычного пользователя не получится. Чтобы разобраться в причинах, нужно немного рассказать о том, как работает агрегация сетевых линков в принципе.

Использовать два и более сетевых интерфейса можно разными способами. Например, выделить один линк как резервный: он будет задействован, только если у основного линка возникнут проблемы. Также агрегацию можно применить для распределения нагрузки, пуская трафик, генерируемый разными клиентами, по разным линкам. В этом случае ширина полосы пропускания увеличивается пропорционально количеству линков — но только если пользователей несколько и доступ к данным они получают с разных сетевых интерфейсов. Скорость доступа к данным для каждого конкретного пользователя не превысит максимальной скорости работы единственного гигабитного линка.

Единственное исключение из этого правила — агрегация на программном уровне (она не требует какого-то особого коммутатора или настроек) по алгоритму Round Robin (на русский язык иногда переводится как циклический режим). При работе по этому алгоритму сетевые интерфейсы используются строго по очереди, что и позволяет достичь эффекта, которого ожидает обычный домашний пользователь: скорость передачи данных между NAS и любым другим устройством (разумеется, также использующим скоростной линк) будет складываться из суммарной пропускной способности всех агрегированных линков. Таким образом, включение второго порта Ethernet у других производителей — это способ удвоить видимую пользователю скорость работы NAS, вплотную приблизив скорость обмена данными по сети к скорости самих дисков.

А вот в сетевых хранилищах от Synology от агрегации портов обычному пользователю будет мало толка. По какой-то причине разработчики DSM не стали выводить в графический интерфейс возможность использования циклического режима Round Robin. Другие алгоритмы? Пожалуйста! Вот только ни один из них не позволит удвоить скорость передачи данных между NAS и единственным клиентом. Подавляющее большинство покупателей NAS с двумя сетевыми портами не узнает об этой особенности, пока не попробует воспользоваться режимом агрегации.

В DSM доступен выбор одного из нескольких алгоритмов агрегации.

При этом DSM работает поверх сборки Linux, в ядре которой агрегация Round Robin присутствует. Соответственно, можно попробовать ее включить. Для этого достаточно изменить единственный байт в единственном текстовом файле. Итак:

- Создаем сетевое соединение, используя агрегацию по методу Adaptive Load Balancing. Внимание: на момент создания соединения оба сетевых порта должны быть уже подключены к коммутатору, причем скорость портов должна совпадать. Кстати, рекомендую сразу же увеличить MTU до 9000.

- Заходим через SSH с правами root и открываем файл /etc/sysconfig/network-scripts/ifcfg-bond1 (или bond0, в зависимости от настроек) на редактирование.

- Находим строку BONDING_OPTS и меняем значение 6 на 0. Сохраняем файл.

- Перезапускаем сеть командой /etc/rc. network restart (если после этого открыть окно настроек агрегации в веб-интерфейсе DSM, в нем не будет выбран ни один из вариантов).

Если все сделано правильно, мы получим удвоенную скорость передачи данных между NAS и… собственно, между NAS и любым другим устройством, которое либо также использует агрегацию Round Robin (проверено на двух экземплярах Synology, подключенных к одному гигабитному коммутатору), либо подключено к тому же коммутатору по скоростному каналу на 2,5, 5 или 10 Гбит/с (проверено с собственным компьютером).

Думаю, очевидно, что в твоем компьютере при этом должен быть установлен либо один скоростной сетевой интерфейс (подключенный к скоростному порту мультигигабитного коммутатора), либо два гигабитных (можно подключить к тому же гигабитному коммутатору, к которому подключен NAS).

Еще более быстрый Ethernet

Агрегация сетевых портов — отличная вещь с одним маленьким ограничением: работает только в довольно дорогих моделях, в которых второй сетевой порт присутствует как класс. Большинство же доступных по цене моделей Synology (в том числе исключительно популярная модель DS218+, а также недорогие модели DS118j и DS220j), увы, оборудованы единственным сетевым портом. Как-либо увеличить скорость доступа штатными средствами невозможно — только переходить на более дорогую модель, оборудованную двумя портами Ethernet.

Попробуем очевидный вариант: подключаем гигабитный сетевой адаптер к порту USB в надежде настроить агрегацию. Промах, причем двойной: адаптер системой не опознан, пришлось искать драйвер; и даже после его установки возможности настроить агрегацию в системе так и не появилось. Дополнительный сетевой интерфейс не был пронумерован, оба порта (и встроенный, и USB) показаны в интерфейсе под названием LAN. Что ж, никто и не обещал, что в устройстве с одним портом разработчики DSM оставят настройки агрегации.

Остается другой вариант: использовать внешний сетевой адаптер со скоростью 2,5 или 5 Гбит/с. В продаже есть множество вариантов, все они основаны на одном из двух чипсетов: Marvell (Aquantia) AQtion AQC111U либо Realtek RTL8156 (на котором построен добрый десяток моделей, отличающихся в основном формой корпуса, а иногда и вовсе только названием производителя).

Вариант 1: 5 Гбит, адаптер QNA-UC5G1T на чипсете AQtion AQC111U

Пробуем подключить пятигигабитный адаптер от основного конкурента Synology — компании QNAP. Просто взять и подключить адаптер, разумеется, недостаточно: DSM корректно определит устройство, но без драйвера для AQC111U не увидит сетевого линка. На помощь приходит GitHub: драйверы для чипсета AQC111U в формате пакета для DSM можно скачать отсюда.

В список совместимых моделей входят DS918+, DS620slim, DS1019+, DS718+, DS418play, а также DS218+. Впрочем, сборки доступны и для более старых чипсетов, но — без гарантии. При этом поддерживаются в основном устройства с процессорами Intel; модели на чипах Realtek (архитектура ARMv8) не поддерживаются, так что использовать адаптер с DS218, DS218Play, DS220j или DS118j не удастся.

А что насчет современных устройств — DS220+, DS720+, DS420+ и так далее? Для них еще не выложены нужные библиотеки и фреймворки, которые необходимы для компиляции драйверов.

Устанавливается драйвер просто: достаточно использовать команду Manual Install из раздела Packages. После установки драйвер становится доступным в виде установленного пакета; его нужно будет запустить.

Драйвер готов к работе, но рекомендуется его предварительно настроить, изменив в свойствах адаптера MTU = 9000. В настройках адаптер будет выглядеть примерно так:

На этом не все. Пятигигабитный адаптер склонен к нагреву, а где нагрев — там и тротлинг. Соответственно, стоит отключить температурный тротлинг, а чтобы не возникал перегрев — включить EEE (Energy Efficient Ethernet). Это можно сделать двумя командами в терминале (предполагается, что идентификатор подключения — eth1, что верно для систем с единственным встроенным сетевым портом):

Продолжение доступно только участникам

Вариант 1. Присоединись к сообществу «Xakep. ru», чтобы читать все материалы на сайте

Членство в сообществе в течение указанного срока откроет тебе доступ ко ВСЕМ материалам «Хакера», позволит скачивать выпуски в PDF, отключит рекламу на сайте и увеличит личную накопительную скидку! Подробнее

https://habr. com/ru/post/452798/

https://xakep. ru/2020/09/02/synology/